在当今信息爆炸的时代,数据成为了最有价值的资源之一。无论是企业决策、市场分析,还是个人兴趣研究,数据都扮演着至关重要的角色。然而,获取大量、精准的数据并非易事。这时,爬虫技术应运而生,成为了数据采集的重要工具。与此同时,随着自媒体的兴起,公众号成为了许多人展示才华、分享知识的平台。将爬虫技术与公众号运营相结合,不仅能高效获取数据,还能通过数据分析提升内容质量,吸引更多读者,从而实现副业创收。本文将深入探讨如何利用爬虫技术助力公众号运营,打造一个成功的爬虫副业公众号。

首先,我们需要明确爬虫技术的核心作用。爬虫,顾名思义,是一种自动抓取互联网信息的程序。通过编写特定的代码,爬虫可以按照预设的规则,从网站上抓取所需的数据。这些数据可以是新闻资讯、用户评论、商品信息等,几乎涵盖了互联网上的所有内容。对于公众号运营者而言,爬虫技术可以极大地提高数据采集的效率,节省大量时间和人力成本。

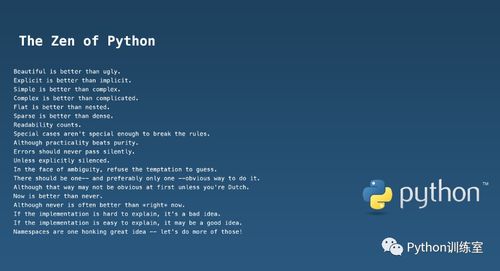

然而,爬虫技术的应用并非毫无门槛。要想高效地利用爬虫,首先需要掌握一定的编程知识。Python作为一种简洁、易学的编程语言,成为了爬虫开发的首选。通过学习Python的基础语法、网络请求库(如requests)、数据解析库(如BeautifulSoup、>xpath)等,可以逐步掌握爬虫的开发技巧。此外,了解HTTP协议、网页结构、反爬虫机制等也是必不可少的。

在掌握了爬虫技术后,如何将其应用于公众号运营呢?这里有几个关键步骤。首先,明确数据需求。不同的公众号定位不同,所需的数据类型也各异。例如,一个专注于科技资讯的公众号,可能需要抓取最新的科技新闻、技术动态等;而一个主打美食推荐的公众号,则可能需要采集各大美食网站的用户评价、菜谱信息等。明确数据需求后,可以更有针对性地编写爬虫程序,提高数据采集的精准度。

其次,设计高效的爬虫策略。爬虫程序的运行效率直接影响到数据采集的时效性。在设计爬虫时,需要注意以下几点:一是合理设置爬取频率,避免因频繁请求而被目标网站封禁;二是优化数据解析逻辑,确保快速准确地提取所需信息;三是考虑数据存储方式,选择合适的数据库或文件格式存储爬取到的数据。

接下来,将爬取到的数据应用于公众号内容创作。数据本身并无价值,只有经过分析和应用,才能转化为有价值的情報。例如,通过分析用户评论数据,可以了解读者的兴趣点和关注点,从而调整内容方向,提升文章的阅读量和互动率;通过分析竞品公众号的数据,可以了解市场动态,找到差异化竞争的策略。

此外,还可以利用爬虫技术实现公众号的自动化运营。例如,通过爬取相关领域的热门话题,自动生成文章选题;通过爬取用户行为数据,自动推送个性化内容;通过爬取竞品公众号的运营数据,自动生成分析报告等。这些自动化功能不仅可以提高运营效率,还能减少人为失误,提升公众号的整体质量。

当然,爬虫技术的应用也面临一些法律和道德风险。在爬取数据时,必须遵守相关法律法规,尊重目标网站的版权和隐私政策。避免爬取敏感信息、非法数据,以免引发法律纠纷。同时,要注重数据的安全性,防止数据泄露和滥用。

在实际操作中,还可以结合一些第三方工具和平台,进一步提升爬虫副业公众号的运营效果。例如,利用云服务器部署爬虫程序,实现24小时不间断数据采集;利用数据分析工具,对爬取到的数据进行深度挖掘和可视化展示;利用微信小程序,增强公众号的互动性和用户体验等。

总之,爬虫技术为公众号运营提供了强大的数据支持,是实现副业创收的有效途径。通过掌握爬虫技术,明确数据需求,设计高效爬虫策略,将数据应用于内容创作和自动化运营,可以有效提升公众号的质量和影响力。同时,注重法律和道德规范,确保数据安全和合法使用,才能在激烈的竞争中立于不败之地。

在这个数据驱动的时代,爬虫副业公众号不仅是一个创收手段,更是一个展示个人能力和价值的平台。希望本文的探讨能为大家提供一些有益的启示,助力大家在爬虫副业公众号的道路上走得更远、更稳。